# Muster oder Zufall? Wie KI selbst das Offensichtliche übersieht

Ist es möglich, dass fortschrittliche KI offensichtliche Muster nicht erkennt oder sogar als Zufall abtut? Trotz der steigenden Leistung von KI-Suchmaschinen und Algorithmen stoßen wir auf Situationen, in denen einfache Muster übersehen werden. Die Frage ist: Warum? Was sind die Gründe für diese Fehler in den Algorithmen? Außerdem, wie wirkt sich die Art und Weise, wie Daten verarbeitet werden, auf die Fähigkeit der KI aus, Muster richtig zu erkennen?

Begeben Sie sich auf eine Entdeckungsreise in die Welt der Mustererkennung. Verstehen Sie, warum selbst die modernste Technologie manchmal versagt.

Die Bedeutung von Mustererkennung in der KI

Mustererkennung ist entscheidend für die Fortentwicklung künstlicher Intelligenz (KI). Neuronale Netze nutzen Musterabgleich, um Daten zu analysieren und zu erkennen. Das spielt vor allem in der Bilderkennung eine große Rolle. Techniken des maschinellen Lernens und des Deep Learnings werden eingesetzt, um visuelle Informationen genau zu verarbeiten.

Grundlagen der Mustererkennung

Algorithmen der Mustererkennung sind darauf ausgerichtet, Muster in großen Datenmengen zu finden. Maschinenelles Lernen und Deep Learning befähigen neuronale Netze, Muster effektiver zu erkennen. Ein tiefes Verständnis dieser Techniken ist notwendig, um ihre Möglichkeiten und Grenzen zu begreifen.

Anwendungen der Mustererkennung in unterschiedlichen Feldern

Die Einsatzgebiete der Mustererkennung sind breit gefächert und durchdringen viele Branchen. Im Gesundheitswesen unterstützt sie die Diagnose von Krankheiten mittels Bildanalyse. In der Finanzwelt dient sie dazu, Betrug durch die Identifizierung verdächtiger Transaktionen aufzudecken.

Bilderkennung ist ebenfalls in der Automobilbranche von Bedeutung, besonders bei der Entwicklung selbstfahrender Fahrzeuge. Diese Beispiele zeigen, wie wichtig Musterabgleich und die dahintersteckenden Technologien für den Fortschritt diverser Bereiche sind.

Warum Künstliche Intelligenz manchmal scheitert

Künstliche Intelligenz kann viele unserer täglichen Probleme angehen. Trotzdem ist KI nicht perfekt. Es existieren diverse Faktoren, die zu Fehlern führen können.

Typische Fehlerquellen bei KI-Algorithmen

Ein Hauptproblem ist die Fehlinterpretation durch falsch kalibrierte Algorithmen. Oft mündet dies in Biases in der KI, wenn Entscheidungen aufgrund voreingenommener Daten falsch sind. Die richtige Algorithmen-Anpassung ist entscheidend für präzise und faire Ergebnisse. Übertrainierung ist ein weiteres Problem, wenn das Modell nur unter Trainingsbedingungen funktioniert, aber real nicht.

Beispiele aus der Praxis

Ein bekanntes Beispiel ist Amazons KI-basiertes Bewerbungssystem. Es bevorzugte Männer über Frauen, wodurch die Notwendigkeit einer sorgfältigen Algorithmen-Anpassung hervorgehoben wurde. Ein anderer Bereich ist die medizinische Diagnostik. Hier führte Übertrainierung dazu, dass Modelle bei echten Patienten nicht funktionierten, da sie zu spezifisch trainiert waren.

Textanalyse und ihre Grenzen

In den letzten Jahren hat die Natürliche Sprachverarbeitung beachtliche Fortschritte verzeichnet. Dennoch finden Algorithmen der KI oft ihre Schranken. Vor allem bei der semantischen Analyse treten Probleme auf. Mehrdeutige Wörter stellen eine Herausforderung dar, da sie je nach Kontext variieren können.

Ein Algorithmus, der kein umfassendes Kontextverständnis aufweist, scheitert oft daran, diese Nuancen zu verstehen. Ein weiteres signifikantes Hindernis ist die Erkennung von Ironie und Sarkasmus in Texten. Menschen gebrauchen ironische Bemerkungen, die vom wörtlichen Sinn abweichen.

Dies führt oft dazu, dass KI den wahren Sinn eines Ausspruchs missversteht. Ein simples „Na toll!“ kann somit völlig falsch interpretiert werden, je nachdem wie es gemeint ist. Um solche Herausforderungen zu überwinden, muss die Natürliche Sprachverarbeitung weiterentwickelt werden.

Ein Fortschritt in semantischer Analyse und Kontextverständnis ist nötig. Nur so können wir die Komplexität menschlicher Kommunikation entschlüsseln.

Wie KI den Musterabgleich durchführt

Künstliche Intelligenz setzt fortschrittliche Techniken ein, um Musterabgleich effizient und genau durchzuführen. Sie verwendet dabei Algorithmen und Technologien wie Computer Vision. Diese erkennen und analysieren Muster in umfangreichen Datenmengen. Im Folgenden werden die verbreiteten Techniken und deren Herausforderungen näher betrachtet.

Techniken des Musterabgleichs

Im Bereich der künstlichen Intelligenz stützt sich der Musterabgleich auf diverse Methoden. Eine davon ist der Inhaltsvergleich, der Daten auf ähnliche Inhalte prüft. Zudem spielt Computer Vision eine wichtige Rolle, insbesondere bei Gesichts- und Objekterkennung. Die kontinuierliche Schulung der KI durch Lernmethoden verbessert die Genauigkeit im Musterabgleich.

Komplexität und Herausforderungen

Die Herausforderungen im Musterabgleich wachsen mit der Zunahme der Datenmenge. Ein Kernproblem ist das Skalieren der Algorithmen für die Datenbewältigung. KI-Systeme müssen sich zudem schnell an neue Muster anpassen können. Dies erfordert die ständige Weiterentwicklung von Lernmethoden. Der dynamische und kontinuierliche Prozess zeigt die Komplexität des Musterabgleichs in der Weiterentwicklung fortschrittlicher KI.

Die Rolle der Datensynchronisierung

Effiziente Datensynchronisierung ist entscheidend für KI-Systeme. Sie stellt sicher, dass Daten über Plattformen hinweg konsistent sind. Dadurch wird die Datenintegrität gefördert und die Funktionalität von Datenbanksystemen optimiert.

Warum Datenabgleich wichtig ist

Der Datenabgleich ist zentral, um Konsistenz über alle Benutzer und Systeme hinweg zu gewährleisten. Er erlaubt Echtzeit-Datenabgleich, was die Entscheidungsfindung beschleunigt. Die Aktualität von Daten ist vital, damit Systeme stets mit den neuesten Informationen arbeiten. So bleibt die Datenintegrität durchgehend gesichert.

Methoden der Datensynchronisierung

Die Datensynchronisierung nutzt verschiedene Ansätze, angepasst an spezielle Datenbanksysteme. Batch-Updates synchronisieren Daten in regelmäßigen Abständen. Eine andere Methode ist der Echtzeit-Datenabgleich, der Daten sofort nach einer Änderung aktualisiert. Diese Strategien sorgen für eine effiziente Datenaktualisierung und halten Systeme synchron.

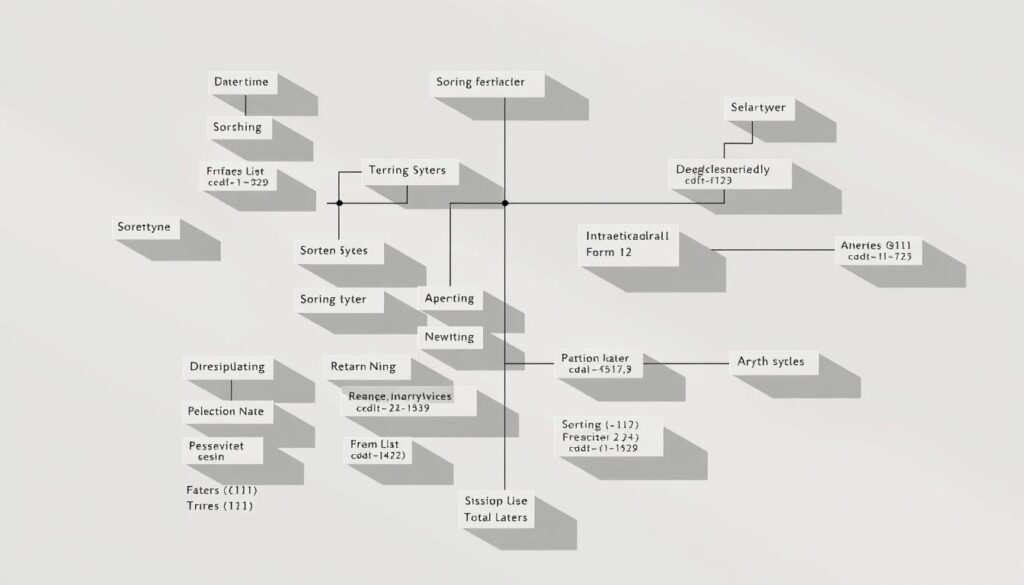

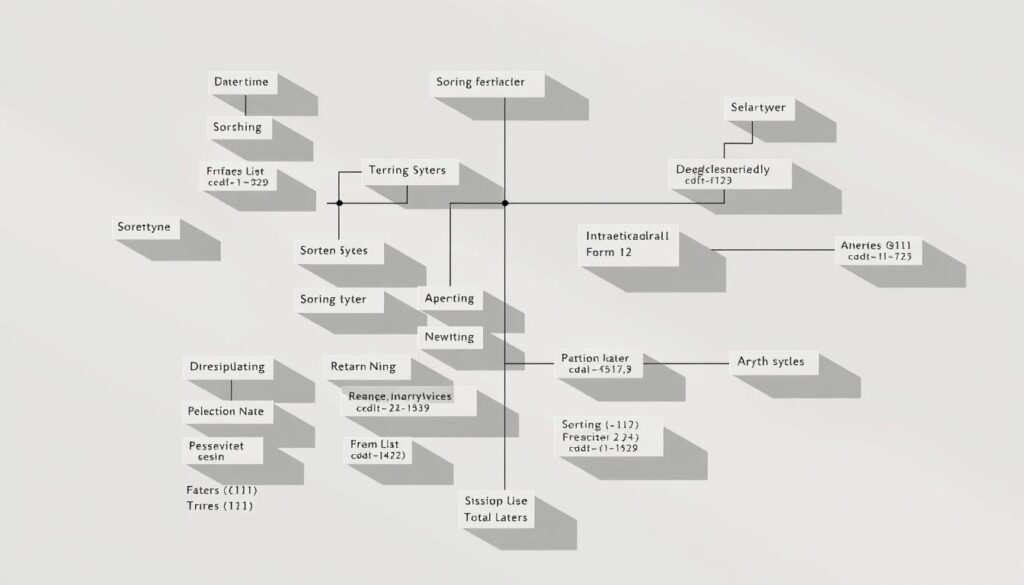

Vergleichsalgorithmen und ihre Relevanz

Vergleichsalgorithmen sind entscheidend in der Datenverarbeitung. Sie analysieren und ordnen große Datenmengen. Dabei sind Sortieralgorithmen von besonderer Bedeutung. Sie bilden den Kern vieler Datenverarbeitungsprozesse. Dank dieser Algorithmen wird die Effizienz gesteigert. Das ist vor allem für die Big Data-Analyse essenziell.

Arten von Vergleichsalgorithmen

Die Arten von Vergleichsalgorithmen variieren nach Einsatzgebiet. Zu den häufigsten gehören:

- Sortieralgorithmen: Sie ordnen Daten folgerichtig an.

- Ähnlichkeitsmessung: Diese Algorithmen finden und vergleichen Ähnlichkeiten, was in der Mustererkennung wertvoll ist.

- Suchalgorithmen: Sie dienen dem Auffinden spezifischer Datenpunkte in großen Datenmengen.

Anwendungsfälle für Vergleichsalgorithmen

Vergleichsalgorithmen sind in vielen Feldern nützlich. Besonders in der Big Data-Analyse erleichtern sie die Verarbeitung großer Datenmengen. Die Ähnlichkeitsmessung wird in Bild- und Sprachanalyse zur Mustererkennung verwendet. Diese Techniken verbessern die Effizienz und Genauigkeit der Datenanalyse.

Fehlende Daten und ihre Auswirkungen

Datenlücken beeinträchtigen die Qualität von KI-Systemen erheblich. Sie verschlechtern das Training von Algorithmen und wirken sich nachteilig auf die Leistung aus.

Wie fehlende Daten KI beeinflussen

Durch das Fehlen von Daten erhält die KI ein unvollständiges Bild. Dies führt oft zu verzerrten oder ungenauen Ergebnissen. Die Datenqualität ist entscheidend für die Effizienz und Genauigkeit der Modelle. Unvollständige oder inkonsistente Daten können das Training von Algorithmen behindern.

Strategien zum Umgang mit fehlenden Daten

Zur Handhabung fehlender Daten existieren unterschiedliche Methoden. Eine beliebte Strategie ist die Imputation, die das Ersetzen fehlender Werte durch Schätzungen oder Durchschnittswerte umfasst. Außerdem können Algorithmen angepasst werden, um besser mit Datenlücken umzugehen. Präventive Maßnahmen und eine sorgfältige Datenprüfung sind entscheidend, um die Auswirkungen zu minimieren.

Die Rolle der Textverarbeitung in der KI

Textverarbeitung ist zentral für die Künstliche Intelligenz. Sie bildet die Grundlage, um natürliche Sprachen zu analysieren und zu interpretieren. Durch Technologien wie Textmining und Sentiment-Analyse können tiefgreifende Einsichten aus umfangreichen Textdaten gezogen werden. Dies eröffnet neue Möglichkeiten für die Entwicklung intelligenter Systeme.

Textverarbeitungs-Tools und -Techniken

Zu den wichtigsten Instrumenten gehört eine Vielzahl von NLP-Bibliotheken, darunter NLTK, SpaCy und Stanford NLP. Diese Tools ermöglichen Informationsgewinnung auf hohem Niveau. Sie schaffen es, komplexe Sprachmodelle zu entwickeln. Diese Modelle sind fähig, natürliche Sprache effektiv zu verstehen und zu verarbeiten.

Herausforderungen bei der Textverarbeitung

Die Verarbeitung natürlicher Sprache ist mit Herausforderungen verbunden. Insbesondere die präzise Kontextinterpretation und zuverlässige Sentiment-Analyse stellen oft große Hürden dar. Sprachmodelle müssen sorgfältig trainiert werden. Sie bedürfen umfangreicher Ressourcen und Daten, um den diversen sprachlichen Nuancen gerecht zu werden.

Duplikaterkennung und ihre Wichtigkeit

Die Rolle der Duplikaterkennung bei der Datenbereinigung ist entscheidend. Sie hilft, die Konsistenz der Datensätze aufrechtzuerhalten. Ohne sie können Redundanzen und Inkonsistenzen erhebliche Probleme verursachen. Dazu gehören Datenüberlastung und verfälschte Analysen. Es ist also kritisch, dass Betriebe angemessene Methoden zur Erkennung von Duplikaten und zur Vermeidung von Redundanzen verwenden.

Was ist Duplikaterkennung?

Die Duplikaterkennung identifiziert identische oder ähnliche Datensätze in einem Datenbestand. Diese Technik ist wesentlich, um Datensatz-Konsistenz zu sichern und unnötige Wiederholungen zu eliminieren. Mithilfe spezifischer Algorithmen lassen sich potenzielle Duplikate zügig aufspüren und bereinigen.

Beispiele für Duplikaterkennung

In Customer-Relationship-Management-Systemen (CRM) ist die Duplikaterkennung oft notwendig. Hier können Kunden mehrfach mit geringfügig unterschiedlichen Daten auftauchen. Diese Methode hilft, solche Redundanzen zu finden und zu vereinheitlichen. So entsteht ein zuverlässiges Kundenprofil. Ein anderes Beispiel ist die akademische Plagiaterkennung. Hier vergleicht das System Texte, um sicherzustellen, dass akademische Arbeiten frei von Duplikaten und unerlaubten Kopien sind.

Fazit

In diesem Artikel beleuchteten wir die entscheidende Rolle der Mustererkennung in der Künstlichen Intelligenz sowie ihre vielfältigen Anwendungen. Musterabgleich stellt dabei eine grundlegende Technik dar. KI-Systeme sind trotz fortschrittlicher Algorithmen jedoch nicht ohne Fehler. Typische Fehlerquellen und die Schwierigkeiten bei der Textverarbeitung unterstreichen die Notwendigkeit stetiger Weiterentwicklungen.

Ein wichtiger Punkt war auch die Bedeutung der Datensynchronisierung und der Umgang mit fehlenden Informationen. Die Zuverlässigkeit von KI hängt stark davon ab, wie gut diese Datenprobleme bewältigt werden. Vergleichsalgorithmen sind entscheidend, um Daten wirksam zu verarbeiten und auszuwerten.

Blickt man in die Zukunft der KI, erscheinen Fortschritte in der Datenverarbeitung als Schlüssel, um KI-Systeme leistungsfähiger und zuverlässiger zu gestalten. Die laufende Evolution in der Mustererkennungs-Technologie verspricht, die Kapazitäten der KI beträchtlich zu verbessern und neue Anwendungsgebiete zu öffnen.

FAQ

Was ist Mustererkennung?

Welche Anwendungen gibt es für Mustererkennung?

Warum scheitert Künstliche Intelligenz manchmal?

Was sind die Herausforderungen bei der Textanalyse?

Wie führt KI den Musterabgleich durch?

Warum ist Datensynchronisierung wichtig?

Welche Arten von Vergleichsalgorithmen gibt es?

Welche Auswirkungen haben fehlende Daten auf KI?

Welche Tools und Techniken werden in der Textverarbeitung verwendet?

Was ist Duplikaterkennung?

Welche Beispiele gibt es für Duplikaterkennung?

# Muster oder Zufall? Wie KI selbst das Offensichtliche übersieht

Ist es möglich, dass fortschrittliche KI offensichtliche Muster nicht erkennt oder sogar als Zufall abtut? Trotz der steigenden Leistung von KI-Suchmaschinen und Algorithmen stoßen wir auf Situationen, in denen einfache Muster übersehen werden. Die Frage ist: Warum? Was sind die Gründe für diese Fehler in den Algorithmen? Außerdem, wie wirkt sich die Art und Weise, wie Daten verarbeitet werden, auf die Fähigkeit der KI aus, Muster richtig zu erkennen?

Begeben Sie sich auf eine Entdeckungsreise in die Welt der Mustererkennung. Verstehen Sie, warum selbst die modernste Technologie manchmal versagt.

Die Bedeutung von Mustererkennung in der KI

Mustererkennung ist entscheidend für die Fortentwicklung künstlicher Intelligenz (KI). Neuronale Netze nutzen Musterabgleich, um Daten zu analysieren und zu erkennen. Das spielt vor allem in der Bilderkennung eine große Rolle. Techniken des maschinellen Lernens und des Deep Learnings werden eingesetzt, um visuelle Informationen genau zu verarbeiten.

Grundlagen der Mustererkennung

Algorithmen der Mustererkennung sind darauf ausgerichtet, Muster in großen Datenmengen zu finden. Maschinenelles Lernen und Deep Learning befähigen neuronale Netze, Muster effektiver zu erkennen. Ein tiefes Verständnis dieser Techniken ist notwendig, um ihre Möglichkeiten und Grenzen zu begreifen.

Anwendungen der Mustererkennung in unterschiedlichen Feldern

Die Einsatzgebiete der Mustererkennung sind breit gefächert und durchdringen viele Branchen. Im Gesundheitswesen unterstützt sie die Diagnose von Krankheiten mittels Bildanalyse. In der Finanzwelt dient sie dazu, Betrug durch die Identifizierung verdächtiger Transaktionen aufzudecken.

Bilderkennung ist ebenfalls in der Automobilbranche von Bedeutung, besonders bei der Entwicklung selbstfahrender Fahrzeuge. Diese Beispiele zeigen, wie wichtig Musterabgleich und die dahintersteckenden Technologien für den Fortschritt diverser Bereiche sind.

Warum Künstliche Intelligenz manchmal scheitert

Künstliche Intelligenz kann viele unserer täglichen Probleme angehen. Trotzdem ist KI nicht perfekt. Es existieren diverse Faktoren, die zu Fehlern führen können.

Typische Fehlerquellen bei KI-Algorithmen

Ein Hauptproblem ist die Fehlinterpretation durch falsch kalibrierte Algorithmen. Oft mündet dies in Biases in der KI, wenn Entscheidungen aufgrund voreingenommener Daten falsch sind. Die richtige Algorithmen-Anpassung ist entscheidend für präzise und faire Ergebnisse. Übertrainierung ist ein weiteres Problem, wenn das Modell nur unter Trainingsbedingungen funktioniert, aber real nicht.

Beispiele aus der Praxis

Ein bekanntes Beispiel ist Amazons KI-basiertes Bewerbungssystem. Es bevorzugte Männer über Frauen, wodurch die Notwendigkeit einer sorgfältigen Algorithmen-Anpassung hervorgehoben wurde. Ein anderer Bereich ist die medizinische Diagnostik. Hier führte Übertrainierung dazu, dass Modelle bei echten Patienten nicht funktionierten, da sie zu spezifisch trainiert waren.

Textanalyse und ihre Grenzen

In den letzten Jahren hat die Natürliche Sprachverarbeitung beachtliche Fortschritte verzeichnet. Dennoch finden Algorithmen der KI oft ihre Schranken. Vor allem bei der semantischen Analyse treten Probleme auf. Mehrdeutige Wörter stellen eine Herausforderung dar, da sie je nach Kontext variieren können.

Ein Algorithmus, der kein umfassendes Kontextverständnis aufweist, scheitert oft daran, diese Nuancen zu verstehen. Ein weiteres signifikantes Hindernis ist die Erkennung von Ironie und Sarkasmus in Texten. Menschen gebrauchen ironische Bemerkungen, die vom wörtlichen Sinn abweichen.

Dies führt oft dazu, dass KI den wahren Sinn eines Ausspruchs missversteht. Ein simples „Na toll!“ kann somit völlig falsch interpretiert werden, je nachdem wie es gemeint ist. Um solche Herausforderungen zu überwinden, muss die Natürliche Sprachverarbeitung weiterentwickelt werden.

Ein Fortschritt in semantischer Analyse und Kontextverständnis ist nötig. Nur so können wir die Komplexität menschlicher Kommunikation entschlüsseln.

Wie KI den Musterabgleich durchführt

Künstliche Intelligenz setzt fortschrittliche Techniken ein, um Musterabgleich effizient und genau durchzuführen. Sie verwendet dabei Algorithmen und Technologien wie Computer Vision. Diese erkennen und analysieren Muster in umfangreichen Datenmengen. Im Folgenden werden die verbreiteten Techniken und deren Herausforderungen näher betrachtet.

Techniken des Musterabgleichs

Im Bereich der künstlichen Intelligenz stützt sich der Musterabgleich auf diverse Methoden. Eine davon ist der Inhaltsvergleich, der Daten auf ähnliche Inhalte prüft. Zudem spielt Computer Vision eine wichtige Rolle, insbesondere bei Gesichts- und Objekterkennung. Die kontinuierliche Schulung der KI durch Lernmethoden verbessert die Genauigkeit im Musterabgleich.

Komplexität und Herausforderungen

Die Herausforderungen im Musterabgleich wachsen mit der Zunahme der Datenmenge. Ein Kernproblem ist das Skalieren der Algorithmen für die Datenbewältigung. KI-Systeme müssen sich zudem schnell an neue Muster anpassen können. Dies erfordert die ständige Weiterentwicklung von Lernmethoden. Der dynamische und kontinuierliche Prozess zeigt die Komplexität des Musterabgleichs in der Weiterentwicklung fortschrittlicher KI.

Die Rolle der Datensynchronisierung

Effiziente Datensynchronisierung ist entscheidend für KI-Systeme. Sie stellt sicher, dass Daten über Plattformen hinweg konsistent sind. Dadurch wird die Datenintegrität gefördert und die Funktionalität von Datenbanksystemen optimiert.

Warum Datenabgleich wichtig ist

Der Datenabgleich ist zentral, um Konsistenz über alle Benutzer und Systeme hinweg zu gewährleisten. Er erlaubt Echtzeit-Datenabgleich, was die Entscheidungsfindung beschleunigt. Die Aktualität von Daten ist vital, damit Systeme stets mit den neuesten Informationen arbeiten. So bleibt die Datenintegrität durchgehend gesichert.

Methoden der Datensynchronisierung

Die Datensynchronisierung nutzt verschiedene Ansätze, angepasst an spezielle Datenbanksysteme. Batch-Updates synchronisieren Daten in regelmäßigen Abständen. Eine andere Methode ist der Echtzeit-Datenabgleich, der Daten sofort nach einer Änderung aktualisiert. Diese Strategien sorgen für eine effiziente Datenaktualisierung und halten Systeme synchron.

Vergleichsalgorithmen und ihre Relevanz

Vergleichsalgorithmen sind entscheidend in der Datenverarbeitung. Sie analysieren und ordnen große Datenmengen. Dabei sind Sortieralgorithmen von besonderer Bedeutung. Sie bilden den Kern vieler Datenverarbeitungsprozesse. Dank dieser Algorithmen wird die Effizienz gesteigert. Das ist vor allem für die Big Data-Analyse essenziell.

Arten von Vergleichsalgorithmen

Die Arten von Vergleichsalgorithmen variieren nach Einsatzgebiet. Zu den häufigsten gehören:

- Sortieralgorithmen: Sie ordnen Daten folgerichtig an.

- Ähnlichkeitsmessung: Diese Algorithmen finden und vergleichen Ähnlichkeiten, was in der Mustererkennung wertvoll ist.

- Suchalgorithmen: Sie dienen dem Auffinden spezifischer Datenpunkte in großen Datenmengen.

Anwendungsfälle für Vergleichsalgorithmen

Vergleichsalgorithmen sind in vielen Feldern nützlich. Besonders in der Big Data-Analyse erleichtern sie die Verarbeitung großer Datenmengen. Die Ähnlichkeitsmessung wird in Bild- und Sprachanalyse zur Mustererkennung verwendet. Diese Techniken verbessern die Effizienz und Genauigkeit der Datenanalyse.

Fehlende Daten und ihre Auswirkungen

Datenlücken beeinträchtigen die Qualität von KI-Systemen erheblich. Sie verschlechtern das Training von Algorithmen und wirken sich nachteilig auf die Leistung aus.

Wie fehlende Daten KI beeinflussen

Durch das Fehlen von Daten erhält die KI ein unvollständiges Bild. Dies führt oft zu verzerrten oder ungenauen Ergebnissen. Die Datenqualität ist entscheidend für die Effizienz und Genauigkeit der Modelle. Unvollständige oder inkonsistente Daten können das Training von Algorithmen behindern.

Strategien zum Umgang mit fehlenden Daten

Zur Handhabung fehlender Daten existieren unterschiedliche Methoden. Eine beliebte Strategie ist die Imputation, die das Ersetzen fehlender Werte durch Schätzungen oder Durchschnittswerte umfasst. Außerdem können Algorithmen angepasst werden, um besser mit Datenlücken umzugehen. Präventive Maßnahmen und eine sorgfältige Datenprüfung sind entscheidend, um die Auswirkungen zu minimieren.

Die Rolle der Textverarbeitung in der KI

Textverarbeitung ist zentral für die Künstliche Intelligenz. Sie bildet die Grundlage, um natürliche Sprachen zu analysieren und zu interpretieren. Durch Technologien wie Textmining und Sentiment-Analyse können tiefgreifende Einsichten aus umfangreichen Textdaten gezogen werden. Dies eröffnet neue Möglichkeiten für die Entwicklung intelligenter Systeme.

Textverarbeitungs-Tools und -Techniken

Zu den wichtigsten Instrumenten gehört eine Vielzahl von NLP-Bibliotheken, darunter NLTK, SpaCy und Stanford NLP. Diese Tools ermöglichen Informationsgewinnung auf hohem Niveau. Sie schaffen es, komplexe Sprachmodelle zu entwickeln. Diese Modelle sind fähig, natürliche Sprache effektiv zu verstehen und zu verarbeiten.

Herausforderungen bei der Textverarbeitung

Die Verarbeitung natürlicher Sprache ist mit Herausforderungen verbunden. Insbesondere die präzise Kontextinterpretation und zuverlässige Sentiment-Analyse stellen oft große Hürden dar. Sprachmodelle müssen sorgfältig trainiert werden. Sie bedürfen umfangreicher Ressourcen und Daten, um den diversen sprachlichen Nuancen gerecht zu werden.

Duplikaterkennung und ihre Wichtigkeit

Die Rolle der Duplikaterkennung bei der Datenbereinigung ist entscheidend. Sie hilft, die Konsistenz der Datensätze aufrechtzuerhalten. Ohne sie können Redundanzen und Inkonsistenzen erhebliche Probleme verursachen. Dazu gehören Datenüberlastung und verfälschte Analysen. Es ist also kritisch, dass Betriebe angemessene Methoden zur Erkennung von Duplikaten und zur Vermeidung von Redundanzen verwenden.

Was ist Duplikaterkennung?

Die Duplikaterkennung identifiziert identische oder ähnliche Datensätze in einem Datenbestand. Diese Technik ist wesentlich, um Datensatz-Konsistenz zu sichern und unnötige Wiederholungen zu eliminieren. Mithilfe spezifischer Algorithmen lassen sich potenzielle Duplikate zügig aufspüren und bereinigen.

Beispiele für Duplikaterkennung

In Customer-Relationship-Management-Systemen (CRM) ist die Duplikaterkennung oft notwendig. Hier können Kunden mehrfach mit geringfügig unterschiedlichen Daten auftauchen. Diese Methode hilft, solche Redundanzen zu finden und zu vereinheitlichen. So entsteht ein zuverlässiges Kundenprofil. Ein anderes Beispiel ist die akademische Plagiaterkennung. Hier vergleicht das System Texte, um sicherzustellen, dass akademische Arbeiten frei von Duplikaten und unerlaubten Kopien sind.

Fazit

In diesem Artikel beleuchteten wir die entscheidende Rolle der Mustererkennung in der Künstlichen Intelligenz sowie ihre vielfältigen Anwendungen. Musterabgleich stellt dabei eine grundlegende Technik dar. KI-Systeme sind trotz fortschrittlicher Algorithmen jedoch nicht ohne Fehler. Typische Fehlerquellen und die Schwierigkeiten bei der Textverarbeitung unterstreichen die Notwendigkeit stetiger Weiterentwicklungen.

Ein wichtiger Punkt war auch die Bedeutung der Datensynchronisierung und der Umgang mit fehlenden Informationen. Die Zuverlässigkeit von KI hängt stark davon ab, wie gut diese Datenprobleme bewältigt werden. Vergleichsalgorithmen sind entscheidend, um Daten wirksam zu verarbeiten und auszuwerten.

Blickt man in die Zukunft der KI, erscheinen Fortschritte in der Datenverarbeitung als Schlüssel, um KI-Systeme leistungsfähiger und zuverlässiger zu gestalten. Die laufende Evolution in der Mustererkennungs-Technologie verspricht, die Kapazitäten der KI beträchtlich zu verbessern und neue Anwendungsgebiete zu öffnen.